(作者署名:虹摄库尔斯克)

斯蒂芬·霍金老爷子逝世的消息成为最近的大新闻。作为一个大半生都依靠人工智能(高智能轮椅)生活的思想家,霍金老爷子却在逝世前提醒人类——“小心人工智能”!

或许是一直与人工智能相伴,霍金老爷子才会说出肺腑之言,提醒人类。但是,各国却没有人听这个老者的话!为了在战争中取得优势,大力发展无人机、无人地面车辆、战斗机器人等在内的含有人工智能因素的致命性自主武器系统。

图片:霍金反对人工智能。

人类这是在给自己挖掘坟墓吗?

霍金的这句警告其实是一封公开信的签名。2015年7月一封要求停止研制具有杀人功能自主武器系统的公开信得到了2万人的签名,签名者主要是人工智能领域的专家以及其他对此话题颇为关切的人,其中就包括著名物理学家斯蒂芬·霍金以及苹果公司联合创始人史蒂夫·沃兹尼亚克。

18张

18张俄六大新武器对中国有何意义

图片:霍金在进行讨论。

所谓的致命性自主武器系统(LAWS),是指能够自主运作的军用机器人,也被称为自主性武器系统、自主性致命机器人(LAR)、战斗机器人或杀手机器人等。目前各国发展的无人飞行器、无人地面车辆、无人水面艇等能够自主运作的武器系统在某种程度上都属于LAWS的范畴。

而还有一些国家和研究机构在研制类似于科幻小说中“杀人蜂”那种微小型无人机,可以杀人于无形。这种武器一旦脱离人类控制,将对人类造成巨大的威胁。

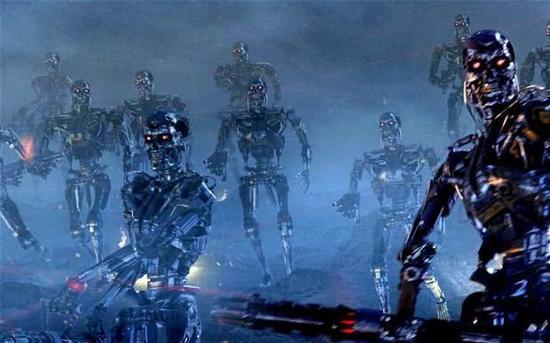

图片:杀人蜂飞行机器人。

这或许要说一个问题——机器人伦理学!机器人能不能伤害人类。1942年,著名的美籍俄罗斯裔科幻作家艾萨克·阿西莫夫首次提出了机器人三定律。

第一定律:机器人不得伤害人类,或坐视人类受到伤害;

第二定律:除非违背第一法则,否则机器人必须服从人类的命令;

第三定律:在不违背第一及第二法则下,机器人必须保护自己。

此后,阿西莫夫又添加了一条定律:第零定律:机器人不得伤害人类族群,或因不作为使人类族群受到伤害。

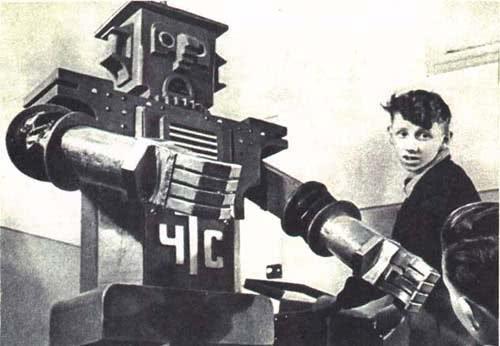

图片:1936年苏联科学家研制的第一种机器人B2M,他的名称就叫“智能机器人”。

但是,现在的机器人发展已经完全舍弃了阿西莫夫制定的三大定律。除了产业机器人外,很大一部分机器人本身就是战斗机械,人类将其设计出来就是为了杀人!

而在战斗机器人的设计领域,美国和俄罗斯走在了前列。美国的无人机,俄罗斯的无人战斗车辆,都是广义上的杀人机器人,只是没有人的模样而已。日本在机器人产业方面也有独到之处。或许是日本人本性使然,特别热衷于研制人的外貌的机器人,还是美女机器人。这已经突破了机器人伦理学的范畴,未来可能直接威胁人类生存。

现在,战斗机器人已经广泛应用到实战中,在减少我军伤亡的情况下,杀伤了大量敌人。从这个意义上来说,战斗机器人是有很大作战价值的,但由于无法录入机器人三大定律,当这些机器人核心被侵入,或者是像“阿尔法狗”一样具有学习能力,自己开创智慧,那么不知道是人类之福还是人类的灾害!

霍金已经不能再给我们答案了!未来的道路需要人类自己去抉择!人类和人工智能的未来会是怎么样的呢?(作者署名:虹摄库尔斯克)

举报成功